Nous allons dans ce cours nous attaquer à des problèmes supervisés que nous allons résoudre à l'aide de modèles linéaires. Autrement dit, nous allons essayer d'approximer les étiquettes de nos données grâce à une combinaison linéaire des variables utilisées pour représenter lesdites données. Dans ce chapitre, nous allons travailler sur des problèmes de régression : nos étiquettes sont des nombres réels (et non pas des catégories).

Un exemple de problème que l'on pourrait chercher à résoudre ici est celui de prédire le nombre d'utilisateurs connectés sur OpenClassrooms (notre étiquette réelle) comme une combinaison linéaire de variables telle que l'heure et le jour de la semaine, à partir des données de l'année passée (nos observations étiquetées).

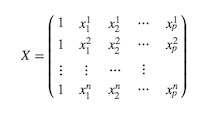

Prenons des données, points en dimensions, représentés par la matrice , avec leurs étiquettes à valeurs réelles, représentées par un vecteur .

Le but de la régression linéaire est de trouver une fonction linéaire qui permette de prédire l'étiquette du i-ème point à partir du vecteur . Autrement dit, peut s'écrire sous la forme

Comment trouver les valeurs des coefficients ?

Maximisation de la vraisemblance

Nous allons pour ce faire nous placer dans un contexte bayésien. Tout de suite les grands mots ! En fait, cela veut dire que nous allons réfléchir en termes de probabilités et chercher les valeurs de pour lesquelles il est le plus vraisemblable d'observer les données qui nous sont données.

Nous allons commencer par supposer que les vecteurs sont les réalisations d'une variable aléatoire -dimensionnelle et que les nombres réels sont les réalisations d'une variable aléatoire .

Pour cela, nous allons avoir besoin de poser quelques hypothèses :

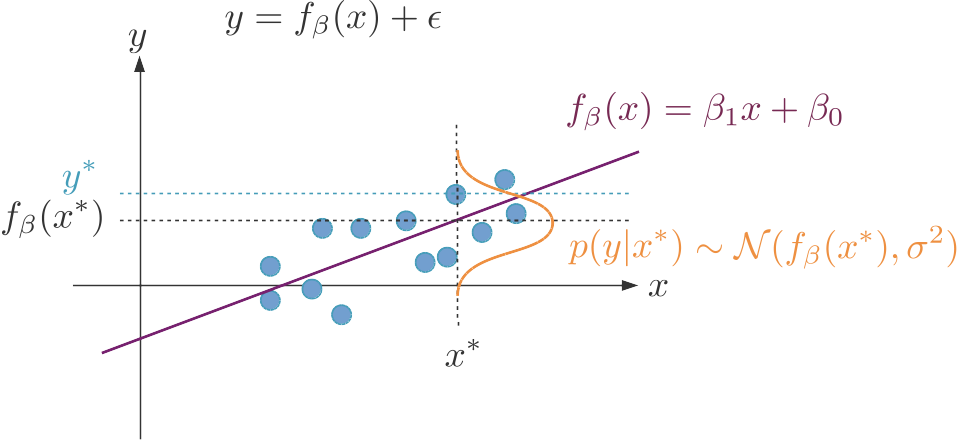

- la première, l'hypothèse de linéarité, est que nous pouvons approximer, pour chacun des points de notre jeu de données, son étiquette par une combinaison linéaire de la valeur des variables qui le décrivent : Le terme de bruit représente la différence entre la combinaison linéaire des variables et la vraie étiquette.

- la deuxième, l'hypothèse de normalité, est que le bruit est gaussien, ou normalement distribué : les ϵi sont la réalisation d'une variable aléatoire gaussienne, centrée en 0 et d'écart-type σ:

- la troisième, l'hypothèse d'indépendance, est que les n couples sont des réalisations indépendantes les unes des autres des variables x et y.

Appelons le vecteur de dimensions (p+1) . Ce vecteur paramétrise notre modèle : une fois que nous avons trouvé la valeur de , notre modèle est entièrement spécifié et nous pouvons l'utiliser pour faire des prédictions.

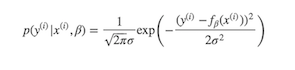

Selon nos hypothèses, la probabilité de étant donné et : suit une distribution normale, centrée en notre prédiction, et d'écart-type .

Vraisemblance

La vraisemblance, que nous allons noter (pour son nom anglais, « likelihood »), c'est la probabilité d'observer nos n observations étant donné

Grâce à l'hypothèse d'indépendance, nous pouvons dire que cette probabilité est le produit des probabilités d'observer chacune des observations :

Par définition de la probabilité conditionnelle,

Nous cherchons donc à trouver qui maximise cette quantité. Comme ne dépend pas de , on peut l'ignorer et nous cherchons donc à résoudre le problème suivant :

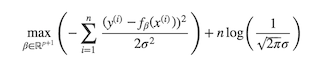

Pour simplifier les calculs, nous allons maximiser non la vraisemblance, mais son logarithme : comme le logarithme est une fonction monotone strictement croissante, les deux sont équivalents. Nous cherchons donc à maximiser le log de vraisemblance, à savoir

En anglais, on appelle ça « log-likelihood maximisation ».

Grâce à nos hypothèses, nous connaissons la forme de : une gaussienne, centrée en la prédiction et d'écart-type . Nous pouvons donc écrire

Nous pouvons prendre le log de cette expression, et trouver le maximum du log de vraisemblance est donc équivalent à

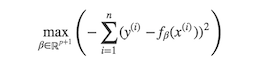

En éliminant de cette équation les termes qui ne dépendent pas de , nous trouvons que maximiser le log de la vraisemblance est équivalent à résoudre

Méthode des moindres carrés

Regardons de plus près le résultat auquel nous sommes arrivés : nous cherchons à minimiser la somme des carrés des différences entre chaque étiquette et sa valeur prédite... autrement dit, maximiser la vraisemblance est équivalent à minimiser la somme des carrés des erreurs !

Cette façon de trouver les coefficients d'une régression linéaire s'appelle la méthode des moindres carrés et est connue depuis Gauss et Legendre, qui faisaient donc déjà du machine learning au début du XIXème siècle 😉

Mais comment résout-on ce problème en pratique ? Pour cela, nous allons passer à une écriture sous forme matricielle. Nous allons commencer par ajouter une colonne de 1 à la matrice de données X : désormais, j'appelle X qui a la forme suivante :

Cela me permet d'écrire comme , et donc sous forme matricielle pour toutes les observations comme le produit . Ainsi, minimiser la somme des carrés des erreurs est équivalent à

Il s'agit désormais de minimiser une forme quadratique convexe, ce qui peut se faire en annulant son gradient en :

Le gradient d'une forme quadratique se calcule de manière analogue à la dérivée d'un polynôme de degré 2 :

Nous cherchons donc à trouver tel que

Si la matrice est inversible, alors la solution s'écrit

Sinon, la solution n'est pas unique, et il faudra utiliser à la place de un pseudo-inverse de , à savoir une matrice telle que

que l'on peut trouver grâce à un algorithme de calcul de pseudo-inverse comme celui de Moore-Penrose.

Interprétation

Un des grands avantages de la régression linéaire est qu'elle produit un modèle interprétable, au sens où il nous permet de comprendre sur quoi se base la prédiction.

Plus précisément, si je rajoute une unité à la valeur de la variable , alors son étiquette augmente de . Plus est grande, plus la variable a un effet important sur la prédiction.

Conclusion

On apprend les coefficients d'une régression linéaire en maximisant le log de la vraisemblance, où, de manière équivalente si l'on suppose l'erreur normalement distribuée et centrée en zéro, en minimisant la somme des carrés des erreurs.

Cette méthode s'appelle la méthode des moindres carrés.

Si la matrice est inversible, la régression linéaire admet une solution unique et explicite.

Sinon, on peut calculer une solution grâce à un algorithme de calcul de pseudo-inverse, mais cette solution n'est pas unique.

Dans scikit-learn, la régression linéaire est implémentée comme LinearRegression dans le module linear_model.