Vous avez vu dans le chapitre précédent l’importance de la crawlabilité, et comment commencer à l’analyser grâce à la Google Search Console. Pour aller plus loin, il est nécessaire d’examiner le comportement de Googlebot grâce aux logs de votre serveur.

Maîtrisez les intérêts de l'analyse de logs

Première chose importante : ce sont vos logs qui contiennent les seules données précises à 100 % sur la façon dont les moteurs de recherche parcourent votre site web. Les logs vous permettent d’avoir des informations qui ne sont présentes nulle part ailleurs.

Voici, listées ci-dessous, trois autres raisons principales pour lesquelles il est important de doubler le suivi de votre crawlabilité sur la Search Console, de l’analyse de logs.

1. Découvrir votre budget de crawl et où il est gaspillé

Vous allez pouvoir découvrir les statistiques de lecture de vos pages par Googlebot. Ceci va donc vous permettre de voir si les pages les plus importantes de votre site sont souvent visitées par Googlebot, ou si celui-ci passe son temps sur les pages les plus anciennes.

Vous saurez notamment :

quelles pages sont le plus souvent vues par Googlebot ;

le ratio entre le nombre de pages visitées par celui-ci et le nombre total de pages de votre site.

Vous découvrirez également si votre site est exploré dans son entièreté, ou si le robot de Google est bloqué à certains endroits.

Avec toutes ces informations, vous pourrez donc prendre les décisions qui s’imposent. Prenons un exemple concret de cas où ces informations pourraient vous êtes utiles.

Vous êtes propriétaire d’un site e-commerce ; grâce à l’analyse de logs, vous remarquez que vos produits de la saison passée sont beaucoup plus consultés que les nouveaux produits. Vous pouvez donc, soit faire des promos sur ces produits pour écouler le stock, les enlever de votre catalogue et rediriger vers vos nouveaux produits, soit ajouter un lien pour encourager Google à aller les visiter.

2. Identifier les pages qui ne sont pas souvent/pas du tout parcourues

Vous pourrez également trier les pages par fréquence de crawling, et donc découvrir les pages qui sont les moins vues sur votre site.

3. Identifier les pages orphelines

Ce sont des pages présentes sur votre site, mais qui ne sont référencées par aucun lien. Google a pu les découvrir grâce au sitemap par exemple, mais elles ne se sont trouvables ni dans les menus, ni dans d’autres pages ou articles.

Récupérez votre fichier de log

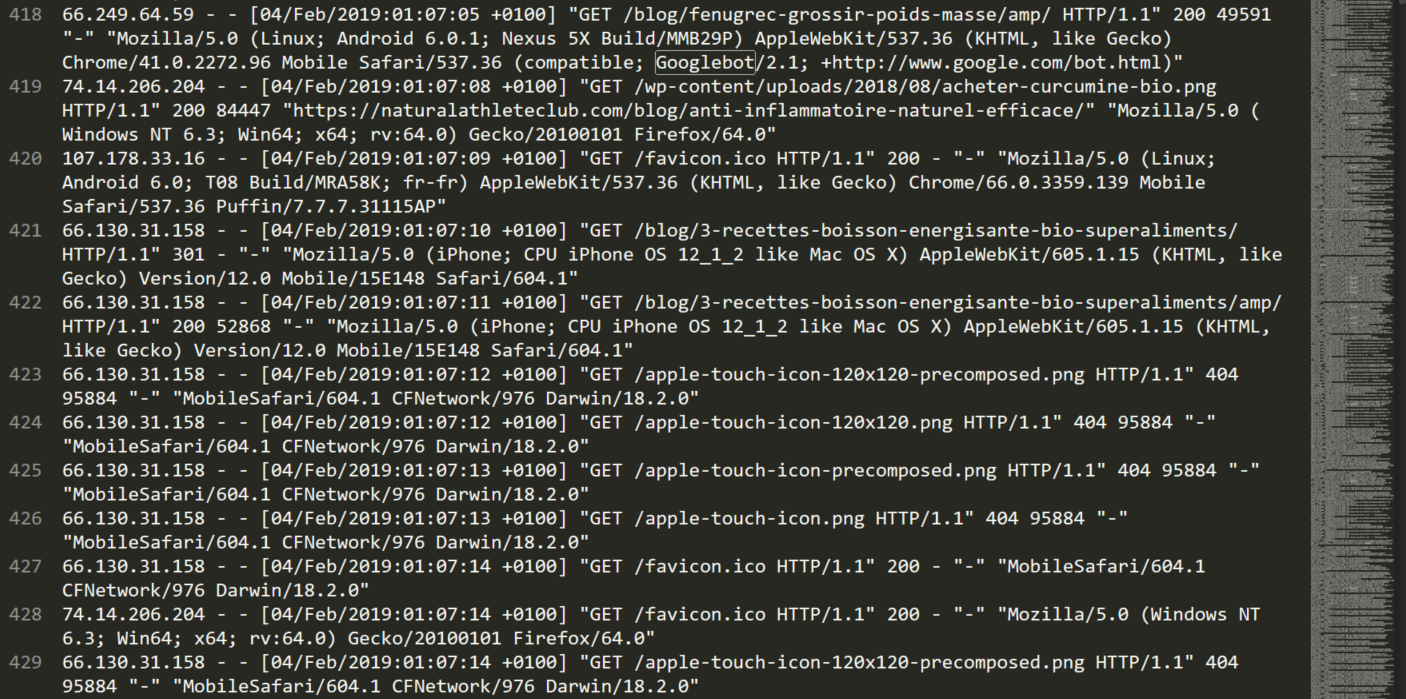

Voici à quoi ressemble une infime partie du contenu d’un fichier de log :

Cette question dépend grandement du logiciel serveur, et donc de l’hébergeur que vous utilisez.

Voici comment récupérer les logs :

Hébergeur 1&1 IONOS

connectez-vous en FTP ;

allez dans le répertoire des logs (niveau supérieur du répertoire) ;

les logs auront la forme : access.log.XX.gz.

Hébergeur OVH

Il vous suffit d’aller sur la page https://logs.ovh.net/votre-nom-de-domaine/ pour pouvoir les télécharger.

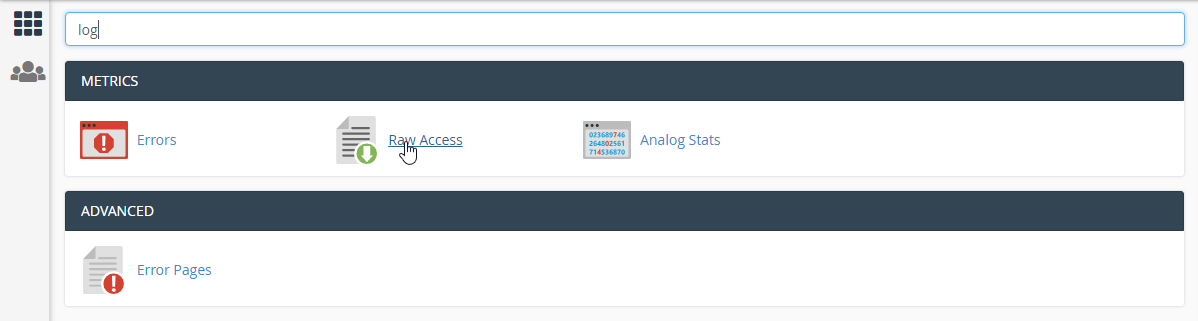

Hébergeur utilisant Cpanel

dans la barre de recherche, tapez “log” ;

cliquez sur “Raw Access” (ou "Accès brut" en français) ;

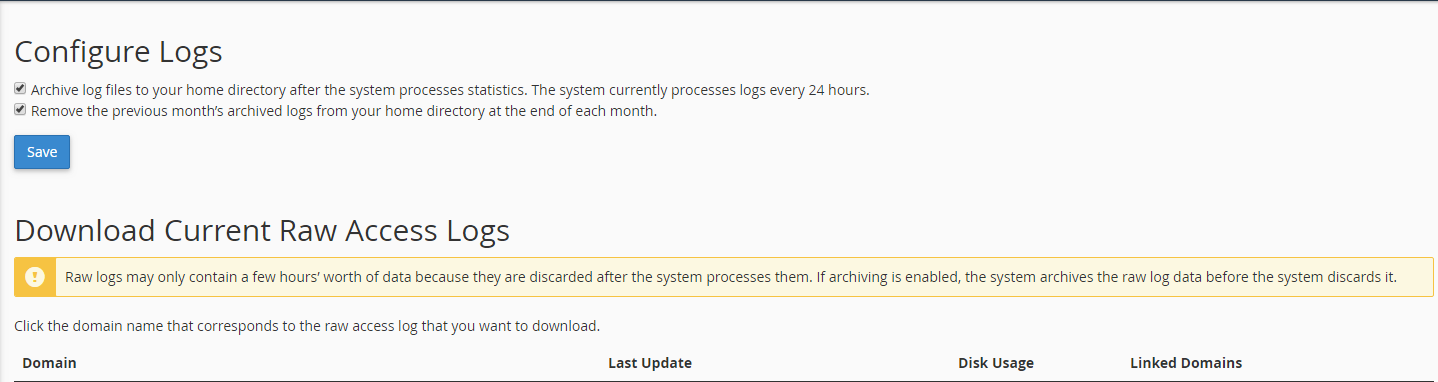

vous obtiendrez l’écran ci-dessous :

si les cases de configuration ne sont pas cochées, pensez à le faire ! En effet, dans le cas contraire, vous n’aurez que le fichier de log de la journée, ce qui n’est pas suffisant ;

pour obtenir vos logs, il vous suffit ensuite de cliquer sur le nom de domaine correspondant dans la partie “Domain”.

Utilisez les bons outils pour analyser vos logs

Votre fichier de log tel quel ne sera pas utilisable. En effet, vous trouverez dedans toutes les demandes HTTP faites à votre serveur, et pas seulement celles de Googlebot.

De plus, après avoir filtré votre fichier, il faudra le mettre en forme et en tirer des graphiques pour pouvoir analyser le comportement de Googlebot.

Voici donc une liste des outils que vous pouvez utiliser pour vous faciliter le travail :

Outils gratuits

Oncrawl : cet analyseur de log est gratuit et open source ;

Seolyzer : cet outil français est gratuit, avec la particularité d’être facilement installable ;

un outil de traitement de données comme Excel ou GoogleSheets : il est aussi possible d’analyser vos logs directement sur Excel. En effet, un fichier de log étant un fichier texte, il peut facilement se convertir en fichier csv, puis être importé dans un tableur. Vous pourrez ensuite utiliser les fonctionnalités d’Excel (par exemple les filtres puis les tableaux croisés dynamiques) pour analyser vos logs.

Payants

Screaming frog log file analyzer : Screaming frog est l’outil le plus connu de crawling de site web, et possède également un outil d’analyse de log. Il bénéficie d’une version gratuite (mais très limitée), ainsi que d’une version payante (£ 99.00) ;

Botify : crawl et analyse de logs - outil premium avec un prix élevé.

Exemple d'utilisation de SEOlyzer

Prenons pour exemple l’utilisation de SEOlyzer. Voici une vidéo démo qui montre comment vous pouvez vous en servir.

Pour récapituler, voici les écrans qui sont, de mon point de vue, les plus utiles :

l’écran “Codes HTTP”. Cet écran vous permet de voir les codes http retournés par vos pages, et donc les pages en erreur 4xx et 5xx. Il est bien sûr possible de voir une grande partie de ces erreurs dans la Search Console ;

l’analyse de logs permet d’aller plus loin et de vraiment trouver toutes les pages qui retournent ces erreurs, ainsi que de voir le moment précis où ces erreurs sont apparues ;

l’écran “HTTP vs HTTPS” (si votre site est en https). Il vous permet de vérifier que toutes les pages sont bien retournées en HTTPS, et donc que vos redirections HTTP vers HTTPS sont bien paramétrées ;

l’écran “Pages actives”. Cet écran vous permet de voir les pages qui ont reçu au moins une visite depuis les résultats de recherche :

ce qui nous intéresse plus ici, ce sont les pages inactives. Pour les obtenir, c’est très simple, il vous suffit d’exporter la liste de vos pages actives et de la comparer avec la liste des pages de votre site grâce à n’importe quel tableur,

vous pourrez donc obtenir les pages qui ne performent pas en SEO.

l’écran “Les + crawlées”. Comme pour l’écran précédent, ce qui nous intéresse ici est surtout de savoir quelles pages sont les moins crawlées.

Imaginons un cas pratique.

Vous trouvez que votre nouveau produit (https://monsite.com/monnouveauproduit) ne remonte pas dans les résultats de recherche. Après avoir analysé les logs, vous trouvez que sa page est inactive.

Grâce à l’écran des pages les plus crawlées, vous remarquez que cette page est très peu crawlée, ce qui pourrait expliquer qu’elle ne remonte pas dans les résultats de recherche.

Ceci vous amène à auditer votre site. Vous vous rendez compte que cette page est très difficilement accessible, car disponible seulement lors de promotions.

Vous pouvez maintenant prendre les décisions qui s’imposent pour améliorer son référencement !

Comparez vos résultats avec la Search Console

Une fois votre analyse effectuée grâce à l’un des outils ci-dessus, pensez à comparer rapidement vos résultats avec ceux donnés par la Search Console, notamment les pages en erreurs.

L'une des trois situations suivantes se produira alors, et voici ce que chacune signifie pour vous.

1. Vous obtenez des résultats similaires | Cela signifie que vous avez bien fait votre analyse de logs. Vous pouvez donc corriger les erreurs s’il y en a. |

2. Vous découvrez plus d’erreurs grâce à l’analyse de logs | Pas de panique, c’est tout à fait probable : si Googlebot ne crawle pas votre site en entier, il est normal que la Search Console ne répertorie pas toutes les erreurs. |

3. Vous découvrez moins d’erreurs que dans la Search Console | Il vous faut, dans ce cas, regarder si vous n’avez pas fait une erreur dans votre analyse, ou si vous avez pris une période de log suffisamment grande. |

En bref

Les logs sont les seules données précises à 100 % sur le comportement des robots sur votre site.

Grâce à l’analyse de logs, vous pourrez découvrir si Googlebot explore correctement votre site web et vos pages principales.

N’oubliez pas de comparer vos résultats avec la Search Console pour ne rien oublier.

Vous savez maintenant comment décrypter le passage de Googlebot pour analyser la crawlabilité de votre site web. Dans le prochain chapitre, nous verrons en détail comment améliorer sa crawlabilité ainsi que son indexation !