Découvrez ce que signifie la "crawlabilité" d'un site

Rappelez-vous, Googlebot explore le web en suivant les liens présents dans les sites qu’il visite, c’est ce qu’on appelle le crawling.

La “crawlabilité” d’un site web désigne la facilité avec laquelle Googlebot va parcourir votre site et l’analyser. Plus votre crawlabilité est bonne, moins Googlebot a besoin de dépenser de ressources, et plus il va aller explorer votre site en profondeur.

Si votre crawlabilité est mauvaise, il va falloir beaucoup de ressources à Googlebot pour explorer votre site ; il s’arrêtera donc certainement avant d’en avoir fait le tour complet.

Repérez le "crawl budget" accordé à votre site

Googlebot a donc un budget de crawl, c’est à dire une limite pour crawler votre site.

Comment est déterminé ce budget ?

Ce budget dépend de la qualité de votre site au yeux de Google : plus votre site est de qualité et plus vous le mettez régulièrement à jour, en rajoutant de nouveaux contenus, par exemple, plus Googlebot estimera qu’il doit passer souvent sur votre site pour indexer les nouveautés.

Le budget de crawl est donc un bon indicateur de la qualité globale de votre site. Plus le budget est élevé, plus votre site est estimé par Google. Au contraire, moins il est élevé, moins Googlebot passera sur votre site.

Démarrez grâce à la Search Console

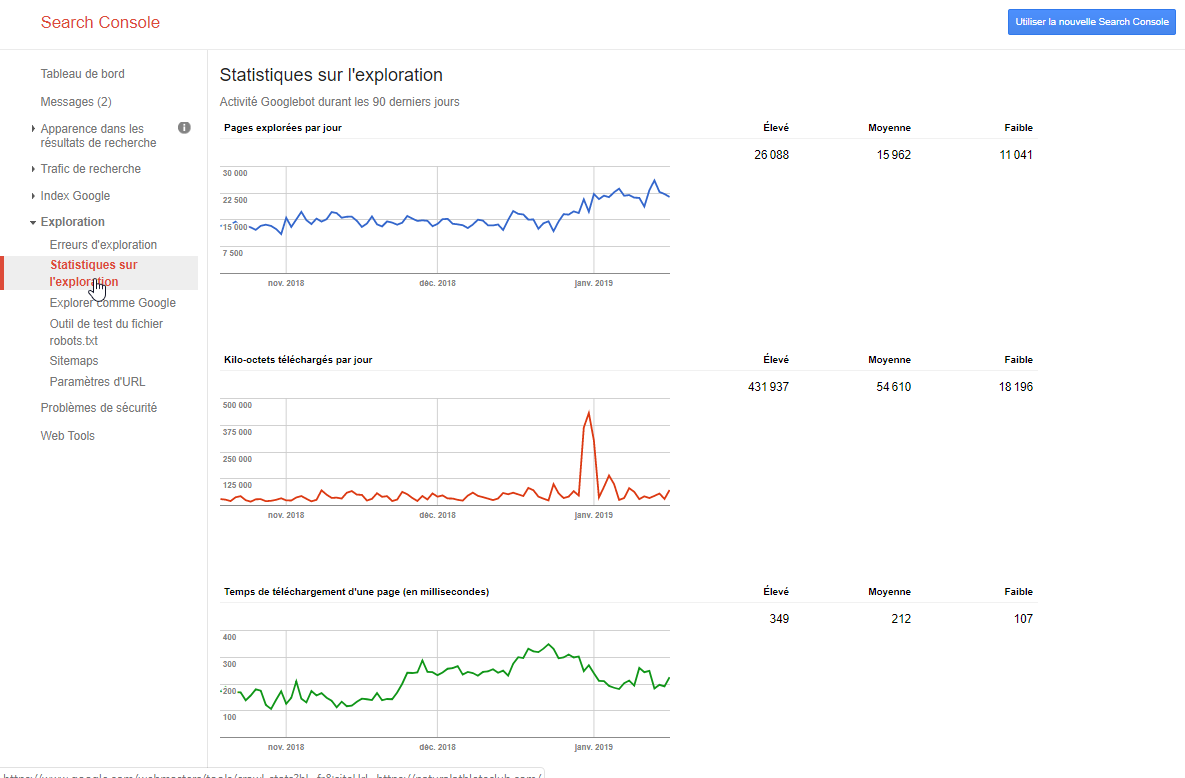

Pour accéder aux statistiques d’exploration (de crawling), allez dans la Search Console, puis :

Exploration > Statistiques sur l’exploration.

Vous obtenez 3 graphiques :

le premier est le nombre de pages explorées par jour ;

le deuxième est le nombre de kilo-octets téléchargés par jour ;

le troisième est le temps de téléchargement d'une page (en millisecondes).

Voici quelques remarques générales sur ces graphiques, avant de les analyser un par un :

tous les graphes doivent être réguliers : si vous découvrez un pic ou au contraire une chute soudaine, c’est que quelque chose s’est passé sur votre site ;

les statistiques se basent sur les 90 derniers jours. Il est important de noter, par exemple dans un fichier Excel, les moyennes de chacun des graphes, et de les suivre sur plusieurs périodes ;

en général, vos graphiques seront tous relativement similaires. Cependant, le graphique des pages explorées par jour est celui sur lequel vous voulez vous concentrer pour mesurer votre crawlabilité.

1. Pages explorées par jour

Ce graphe vous montre le nombre de pages de votre site que Googlebot explore tous les jours. Ce chiffre doit être constant ou à faible fluctuation, voire augmenter au fil des mois, au fur et à mesure que vous rajoutez du contenu. Si vous constatez une chute soudaine, c’est que Googlebot n’arrive certainement plus à accéder à votre contenu.

Vérifiez donc que votre site est toujours accessible, que ses pages ne sont pas bloquées par le robots.txt ou par une balise meta, et qu’il n’y a pas de bug sur vos pages.

Si votre site n’a pas de nouveau contenu, ou que son contenu est très rarement mis à jour, il est aussi possible que Googlebot explore moins votre site.

2. Kilo-octets téléchargés par jour

Ce graphe doit suivre le graphe précédent : plus Googlebot va explorer de pages et donc essayer de les indexer, plus il va les télécharger, ce qui augmente par conséquent le nombre de kilo-octets téléchargés.

Ce graphe correspond à la taille de votre site web. Un site avec énormément de contenu aura forcément un nombre de kilo-octets téléchargés plus important qu’un petit site. Globalement, plus Googlebot télécharge de pages, et donc plus le nombre de kilo-octets est important, plus Google indexe votre site. C’est par conséquent un bon point.

Cependant, cela peut être à double tranchant : il se peut aussi que vos pages soient trop lourdes, ce qui n’est pas du tout une bonne chose aux yeux de Google. Il vous faut donc le comparer avec le graphe de temps de téléchargement d’une page.

3. Temps de téléchargement d'une page

Il est nécessaire ici de savoir que ce temps n’est pas directement lié à la vitesse de vos pages. Ce graphe indique le temps que met Googlebot pour réaliser les requêtes HTTP de vos pages.

Plus le temps de téléchargement est bas, moins Googlebot met de temps à explorer votre site, ce qui est une bonne chose. En l’utilisant conjointement avec le graphe précédent, vous pouvez détecter des problèmes potentiels. Si vous remarquez par exemple une chute du nombre de kilo-octets téléchargés mais un pic sur ce graphe, il y a certainement un problème au niveau de votre serveur. En effet, dans cette situation, Googlebot met plus de temps pour télécharger moins d’informations.

Exemple d'interprétation de ces graphiques

Comme vous le voyez sur l’image ci-dessus, le nombre de pages explorées est stable et augmente ; ce qui est une bonne chose.

En revanche, il y a un pic de kilo-octets téléchargés début janvier 2019, qui ne se reflète directement sur le nombre de pages explorées.

De même, il n’y a pas de pic significatif sur le temps de téléchargement des pages.

Ce pic n’est donc certainement pas causé par un gros problème, car nous aurions vu une récurrence ou un impact sur le temps de téléchargement des pages.

Il est possible que ce pic soit dû à l’ajout massif de contenu d’un seul coup sur le site, mais nous aurions détecté un impact plus grand sur le graphe de pages explorées.

L’hypothèse la plus probable est qu’un contenu trop lourd, tel qu’une vidéo, a été ajouté sur une page, puis rapidement supprimé.

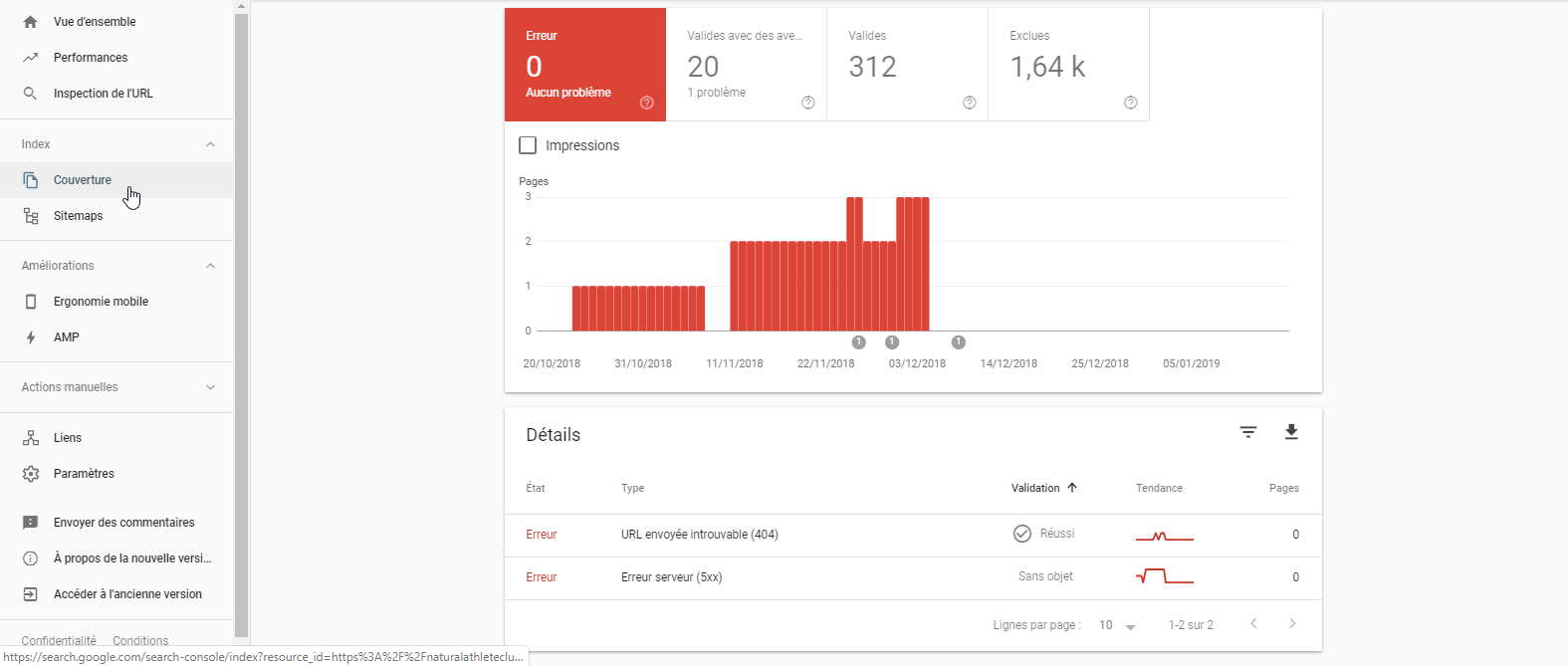

Corrigez les erreurs les plus courantes

Ne laissez surtout pas les erreurs s’accumuler dans la Search Console, car elles auront un impact direct sur la crawlabilité de votre site.

Les deux types d’erreurs principaux sont les suivantes :

les erreurs 404 : Googlebot explore un lien, mais la page en question n’existe pas ou plus. Cela peut provenir d’une simple coquille dans votre lien. Cela peut aussi être causé par le fait que vous avez changé une page d’URL sans effectuer de redirection ;

les erreurs 500 : ce sont des erreurs de serveur. Il faut vérifier qu’il n’y a pas d’erreurs ou d’exceptions dans votre code.

En bref

La crawlabilité désigne la facilité avec laquelle Googlebot explore votre site.

Googlebot a un budget limité pour explorer votre site, il faut donc lui faciliter le travail.

Vous pouvez commencer à détecter des changements de comportement et des erreurs, grâce à la Search Console.

Maintenant que vous savez tout sur la crawlabilité de votre site, nous allons voir, dans le chapitre suivant, comment vérifier en profondeur que Googlebot explore bien tout votre site, grâce à l’analyse de logs !